I en värld där AI tar en allt större plats har datadriven forskning blivit orden på allas läppar. I det här blogginlägget tänkte jag prata lite om vad det innebär att forska med hjälp av stora mängder textdata, primärt inom humaniora. Detta inlägg är det första i en serie om de olika delarna av en data-intensiv forskningsmetodologi. Jag som skriver detta inlägg heter Nina Tahmasebi och är docent inom Språkteknologi och en data scientist, en dataforskare, med över 12 års erfarenhet av storskalig textanalys och kunskapsutvinning.

Först vill jag ta upp två tvetydiga begrepp. Det första gäller termen datadriven; data driver sällan forskning. Människor driver forskning medan svaren kan finnas i data. Därför föredrar jag termen data-intensiv forskning [efn_note] Vi beskriver detta först i A Convergence of Methodologies: Notes on Data-Intensive Humanities Research, DHN 2019. Nina Tahmasebi, Niclas Hagen, Daniel Brodén, Mats Malm [/efn_note] , som tydliggör att medans storskaliga eller komplexa data ligger till grund, är det alltid forskaren som ställer forskningsfrågorna och därmed driver forskningen (inom välutvecklad AI finns det undantag, men detta gäller sällan inom humaniora som vi fokuserar på här).

Nästa begrepp som behöver lite diskussion är data; det vi studerar och det vi utvinner är båda data. Inom textforskningen innebär detta både texten som ligger till grund för vår forskning, och den kunskap vi utvinner ur den. Många gånger kallas även metadata för data i vetenskapliga skrifter. Som jag ser det kan vi prata om primärdata, dvs den text som ligger till grund för vår forskning och är objektet som vi studerar, utvunna data, dvs den kunskap som vi hittat i vår primärdata, samt metadata som används för att beskriva primärdata eller utvunna data. (Det finns många exempel på när metadata är skillnaden mellan att kunna svara på en fråga fullt ut, eller inte, samt att kunna utvärdera betydelsen av sina resultat.) Tyvärr upptäcker jag ofta att jag hamnar i samma fälla, trots att jag gör mitt yttersta att skilja på primärdata och utvunna data. Alltså tror jag att vi får nöja oss med att konstatera att denna tvetydighet ofta finns.

Hur fungerar då data-intensiv forskning?

Allt börjar, eller borde börja, som vanligt med en forskningsfråga; vad är det vi vill ha svar på? Det är först i nästa steg som de stora skillnaderna kommer. De primärdata vi kan använda för att svara på vår fråga kan vara stora när det gäller volym (många olika texter, författare, genrer, etc), eller breda (spänna över lång tid, texter från över tre århundraden är inte ovanligt).[efn_note] Bredd kan också användas för att mena bredd över antal författare eller genrer, t ex, medan storleken framför allt handlar om antalet texter , men i denna text kommer vi att prata om bredd som spann över tid. [/efn_note] Eftersom våra primärdata kan vara större och bredare än de som enskilda forskare kan studera manuellt, och våra datorer är mycket snabbare, kan vi ställa mer avancerade frågor. Vi kan knyta många dimensioner till varann och täcka många fler områden samtidigt.

Sist har vi den magiska komponenten: datorn eller den artificiella intelligensen. Det är den som utför handlingen som länkar vår forskningsfråga till vår primärdata. Den som är snabbare och kraftfullare än vad vi är, den som inte behöver pauser eller kaffe för att orka plöja några sidor till. Den som aldrig gör ”fel” och eliminerar den mänskliga faktorn. Ja, många saker kan man höra om en dator som producent av forskningsresultat. Beroende på vem man frågar, eller inom vilket fält, kan man möta en bild av en allvetande dator som man inte kan leva utan, eller en skarp skepticism; hur ska en dator ta över en människas uppgift? Det senare är vanlig inom humaniora. Både för att det är svårt att ta till sig den nödvändiga kunskapen för att kunna utnyttja datorn som verktyg, men också för att en dator inte kan förstå som en människa.

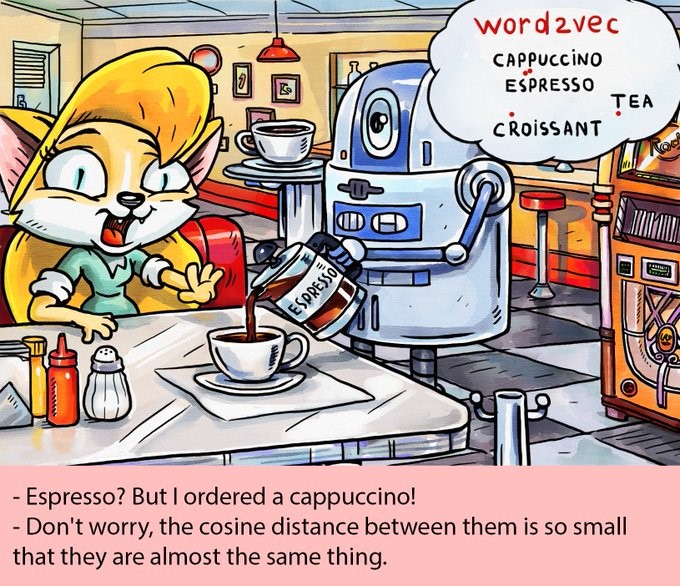

Och där slår vi huvudet på spiken: en dator förstår inte. [efn_note] Som i seriebilden där roboten, alltså datorn, tycker att en espresso och en cappucino är i princip samma sak eftersom orden ligger nära varann i ett vektorrum, trots att alla kaffedrickare mycket väl kan avgöra skillnaderna [/efn_note] En dator utför förutbestämda eller förutsägbara (det är inte alltid vi kan förutsäga vad som skall hända, många av våra processer bygger på randomiserade steg, men processen i sig är ändå förutsägbar) handlingar. Och även om det har gjorts enorma framsteg de senaste åren, framförallt med neurala metoder som mycket bättre approximerar betydelser och kunskap inbäddad i text, så är datorn långt ifrån att förstå. Fortfarande blir subtila nyanser som ironi, sarkasm, logik på högre nivå, anspelningar, poesi, eller känslor, i bästa fall grovhuggna approximationer som ofta ärfelaktiga. En dator når inte det som en människa kan, den saknar förmågan att via fantasin nå nya associationer. Och ändå; datorn är användbar eftersom den kan göra det vi programmerar den till att göra utan att ta rast, eller krångla med att vilja ha ledigt på kvällar och helger. Om vi berättar för en dator på ett förståeligt sätt vad vi är ute efter, och detta är inom räckhåll för datorns kapacitet, kommer den outtröttligt att ta sig igenom all vår data och att ge oss ett resultat.

Nu har vi slutit cirkeln och vi tillbaka hos forskaren igen, datorn har producerat ett resultat åt oss och detta resultat skall utvärderas i förhållande till vår ursprungliga forskningsfråga. Nu ligger allt ansvar hos forskaren; hur kan detta resultat användas? Vad är dess värde? Vilken del av primärdatan har använts till att generera detta resultat och vilken del har exkluderats? För vad är detta resultat representativt?[efn_note] En tydlig missuppfattning är att när resultatet är byggt på stora mängder primärdata, så är det tillförlitligt. Denna missuppfattning kan få allvarliga konsekvenser som kan vittnas bla av kritiken mot Culturomics, se t ex Characterizing the Google Books Corpus: Strong Limits to Inferences of Socio-Cultural and Linguistic Evolution. Vår primärdata är väldigt sällan är ett slumpmässigt urval och därmed kan de resultat som fås med primärdata inte generaliseras till populationen som helhet (här hänvisar jag till Alexander Koplenigs arbete, och primärt hans avhandling). Tex, på webben finns det mycket data att hitta, men ett genomsnitt på webben består framför allt av data genererat av yngre människor bosatta i västvärlden och inte äldre kvinnor från landsbygden i Asien. [/efn_note] Och sist men inte minst, är resultatet ett fullständigt och korrekt svar på vår forskningsfråga? Eftersom våra datorer och artificiella intelligenser är begränsade i sin kapacitet kan de inte utföra en människas handlingar. De kan utföra tydliga instruktioner i stor skala. Dessa behöver inte ge oss ett komplett svar till vår ursprungliga forskningsfråga och det är därför otroligt viktigt att resonera kring vad exakt resultatet är ett svar på. Man kan jämföra en artificiell intelligens med en politiker, en enkel fråga får väldigt sällan ett direkt svar. Istället är det upp till forskaren att bedöma svaret, vrida och vända på det för att avgöra exakt vad vi fått svar på, och hur stor del av vår fråga som har besvarats. Om vi inte har fått ett fullständigt svar får vi ställa ytterligare en fråga ända tills vi är nöjda med svaret (och själv har jag aldrig hört en intervju där journalisten inte behövt ställa följdfrågor eftersom svaret varit komplett direkt). Det är alltid forskaren som besvarar forskningsfrågan till slut även om resultatet är uträknat av en dator på enorma primärdata.

Forskningsmetoden ovan kallar vi ofta för en verifierande metod; data och metod används för att verifiera (eller förkasta) en forskningsfråga. Ett alternativt sätt att använda sig av en data-intensiv forskningsmetodologi är att börja med ett intressant material, välja en eller flera metoder och sen försöka utforska materialet i jakt på intressanta forskningsfrågor. Denna metod kallar vi ofta för en utforskande metod och vi bör använda den utforskande metoden med aktsamhet; det är lätt att se spännande resultat och tappa bort sig i skogen av alla resultat. När vi sen skall komma på vilken forskningsfråga som resultaten kan besvara är det svårt att behålla fokus på forskningsfrågan och bedöma resultatens värde på samma rigorösa sätt som vi annars gör.

Vill du veta mer om vilka aspekter av en data-intensiv forskningsmetodologi som är problematiska eller vilka styrkor den har kan du läsa mer i vår artikel: The Strengths and Pitfalls of Large-Scale Text Mining for Literary Studies . Detta blogginlägg kommer att följas upp med ytterligare några inlägg som tar upp olika aspekter av den data-intensiva processen. Avsnitt två om text som forskningsdata finns här. Några videor från en studiecirkel på samma tema finns här.